OpenAI anuncia la introducción de anuncios en ChatGPT para usuarios adultos de EE. UU.: implicaciones de privacidad y seguridad

Introducción

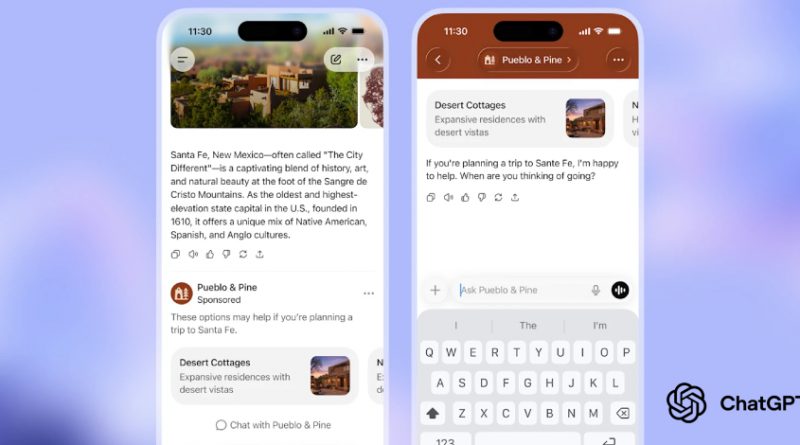

El pasado viernes, OpenAI reveló su plan de desplegar anuncios publicitarios en ChatGPT, afectando inicialmente a los usuarios adultos registrados en Estados Unidos, tanto en la versión gratuita como en la suscripción de bajo coste ChatGPT Go. Esta decisión marca un cambio significativo en la estrategia de monetización del popular asistente conversacional basado en IA y plantea interrogantes de calado sobre la protección de datos, la privacidad y los riesgos de seguridad asociados a la explotación comercial de plataformas de inteligencia artificial a escala global.

Contexto del Incidente o Vulnerabilidad

La expansión internacional de la suscripción ChatGPT Go ha impulsado a OpenAI a buscar nuevas fuentes de ingresos, en un contexto de creciente competencia y elevadas demandas computacionales para mantener modelos avanzados como GPT-4o. El anuncio sobre la inserción de publicidad se produce en medio de un clima de sensibilización pública y regulatoria respecto al uso y tratamiento de datos personales en herramientas de IA. A pesar de que OpenAI ha afirmado que “los datos y conversaciones están protegidos y nunca se venden a anunciantes”, la mera exposición a campañas publicitarias personalizadas puede abrir vectores de ataque indirectos y suponer nuevos desafíos para equipos de seguridad y cumplimiento normativo.

Detalles Técnicos: Vectores de Ataque y Riesgos de Exposición

Aunque OpenAI asegura una barrera entre los datos personales y los anunciantes, la integración de plataformas publicitarias en una aplicación de IA conversacional multiplica la superficie de ataque y los posibles vectores de explotación. Entre los riesgos principales destacan:

– Phishing y publicidad maliciosa (malvertising): La inserción de anuncios, si no se controla rigurosamente, puede ser utilizada por actores maliciosos para distribuir enlaces fraudulentos o exploits, aprovechando el canal de confianza que supone ChatGPT para millones de usuarios.

– Exposición a técnicas de fingerprinting: Los sistemas de publicidad suelen emplear técnicas avanzadas de rastreo y fingerprinting para identificar dispositivos y comportamientos, lo que puede entrar en conflicto con normativas como el GDPR.

– Ataques de ingeniería social: La personalización de anuncios, combinada con los históricos de conversación, podría facilitar campañas de spear phishing o de recopilación de información sensible mediante anuncios aparentemente legítimos.

– Riesgo de integración con frameworks de explotación: Existen precedentes de uso de plataformas legítimas para distribuir cargas útiles a través de anuncios (por ejemplo, mediante exploits empaquetados para Metasploit o Cobalt Strike).

– IoC y TTPs relevantes: MITRE ATT&CK destaca técnicas como T1192 (Spearphishing via Service) y T1566 (Phishing), que podrían verse potenciadas por una integración publicitaria mal gestionada.

Impacto y Riesgos

El alcance potencial del cambio es considerable. ChatGPT cuenta con más de 100 millones de usuarios activos mensuales. La introducción de publicidad, incluso bajo control estricto, puede convertirse en un vector masivo de campañas maliciosas si los controles de seguridad no son exhaustivos. Además, existe el riesgo de que los datos de interacción, aunque no se vendan directamente, sean utilizados para inferir perfiles o patrones de comportamiento útiles para la segmentación publicitaria, lo que podría entrar en conflicto con el GDPR, la CCPA y la futura Directiva NIS2 en Europa.

Medidas de Mitigación y Recomendaciones

– Auditoría regular de plataformas publicitarias: Es imprescindible monitorizar de forma continua los anuncios servidos para detectar posibles campañas maliciosas o intentos de explotación.

– Separación lógica de datos: Garantizar que los datos conversacionales nunca se cruzan con los datos de segmentación publicitaria, empleando técnicas de anonimización y control de acceso basado en roles (RBAC).

– Limitar la personalización: Recomendar a OpenAI y a las empresas que utilicen ChatGPT en entornos corporativos que minimicen la personalización de anuncios y ofrezcan mecanismos de opt-out claro.

– Revisión contractual y legal: Actualizar las cláusulas de privacidad y los acuerdos de tratamiento de datos para reflejar los nuevos flujos de información, en cumplimiento con el GDPR, NIS2 y otras normativas sectoriales.

– Formación y concienciación: Actualizar los programas de concienciación para empleados y usuarios sobre los nuevos riesgos asociados a la exposición publicitaria dentro de plataformas de IA generativa.

Opinión de Expertos

Especialistas en ciberseguridad y privacidad, como el analista de amenazas Raúl Siles (SANS Institute), alertan del potencial de la publicidad para convertirse en un canal privilegiado de ataques dirigidos si las plataformas no auditan de forma exhaustiva los anuncios y sus fuentes. Desde la perspectiva legal, consultores de protección de datos recuerdan que la simple exposición a anuncios personalizados puede activar la aplicación del GDPR, obligando a OpenAI y a las empresas usuarias a revisar su base legal de tratamiento y los mecanismos de obtención de consentimiento explícito.

Implicaciones para Empresas y Usuarios

Las organizaciones que integren ChatGPT en sus operaciones o que permitan a sus empleados el uso de la versión gratuita deben reforzar sus políticas de uso aceptable y monitorizar posibles incidentes derivados de la exposición a anuncios. Los CISOs y responsables de cumplimiento deberán evaluar el impacto en sus DPIA (Data Protection Impact Assessments) y adaptar sus estrategias de gestión de riesgos. Por su parte, los usuarios individuales deben ser conscientes del potencial de exposición a campañas de phishing o malware camufladas como anuncios legítimos.

Conclusiones

La decisión de OpenAI de introducir anuncios en ChatGPT marca un hito en la evolución de la monetización de plataformas de IA generativa, pero también introduce nuevos desafíos de privacidad y seguridad que requieren una respuesta coordinada por parte de los equipos de ciberseguridad, cumplimiento y legal. La transparencia, la auditoría continua y una gestión proactiva de los riesgos serán esenciales para evitar que la publicidad se convierta en el talón de Aquiles de la inteligencia artificial conversacional.

(Fuente: feeds.feedburner.com)