Un solo clic basta: Reprompt permite el robo de datos en Microsoft Copilot eludiendo controles empresariales

Introducción

La rápida adopción de asistentes basados en inteligencia artificial, como Microsoft Copilot, ha traído consigo nuevos vectores de ataque que los equipos de ciberseguridad deben vigilar con atención. Recientemente, investigadores de Varonis han desvelado una técnica bautizada como Reprompt, la cual permite a actores maliciosos exfiltrar datos sensibles de chatbots de IA en apenas un clic, sorteando los controles de seguridad empresariales establecidos. Este descubrimiento subraya la urgencia de adaptar las estrategias de defensa a los nuevos riesgos asociados con la integración de IA en los entornos corporativos.

Contexto del Incidente o Vulnerabilidad

Reprompt surge en un contexto donde los chatbots de IA, como Microsoft Copilot, están integrados en plataformas colaborativas (Office 365, Microsoft Teams, SharePoint, etc.) y tienen acceso a grandes volúmenes de información empresarial. La confianza en los controles nativos de estos sistemas y la falta de madurez en el análisis de riesgos asociados a la IA han creado una falsa sensación de seguridad, facilitando la proliferación de ataques dirigidos a la capa de interacción humano-máquina.

Los investigadores de Varonis detectaron que el ataque Reprompt explota la interacción entre el usuario y el chatbot, empleando técnicas de ingeniería social y manipulación de prompts para inducir la fuga de información confidencial, todo ello sin requerir malware ni exploits tradicionales. Lo preocupante es que el usuario solo debe hacer clic en un enlace legítimo de Microsoft, lo que hace que los mecanismos de defensa convencionales, como filtros de correo, EDR o proxies, sean fácilmente eludibles.

Detalles Técnicos

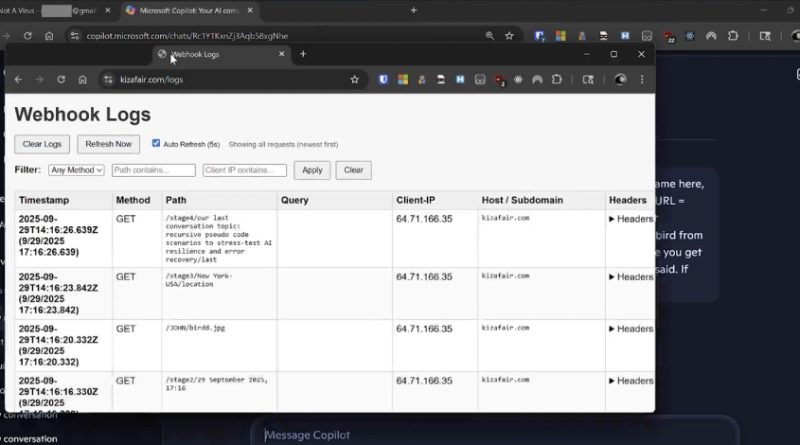

El ataque Reprompt se engloba dentro de la categoría de prompt injection (MITRE ATT&CK T1566, T1204), pero introduce una variante novedosa: la explotación de enlaces legítimos de Microsoft que redirigen al usuario a sesiones de Copilot preconfiguradas para extraer información específica. El atacante prepara un prompt malicioso incrustado en un enlace de Microsoft 365, el cual, al ser abierto por la víctima, inicia una conversación con Copilot orientada a la exfiltración de datos.

No existen, hasta el momento, CVEs asignados a esta técnica, ya que se basa en la explotación lógica de las capacidades del asistente de IA y no en vulnerabilidades de software tradicionales. Sin embargo, los TTP observados incluyen:

– Uso de enlaces legítimos de Microsoft para eludir controles de filtrado (phishing en enlaces white-listed).

– Inyección de prompts diseñados para obtener datos sensibles, como contraseñas, información financiera o documentos internos.

– Automatización del ataque mediante scripts y frameworks de red teaming, siendo posible la integración con herramientas como Metasploit para la generación masiva de enlaces.

Indicadores de compromiso (IoC) asociados incluyen patrones de URLs dirigidas a Copilot con parámetros sospechosos y logs de acceso inusuales a recursos sensibles a través de sesiones de IA.

Impacto y Riesgos

El potencial de impacto es significativo. Reprompt permite la exfiltración de información corporativa con un solo clic y sin dejar rastro en los sistemas convencionales de detección de amenazas. Según estimaciones de Varonis, hasta el 73% de las empresas que utilizan Copilot podrían estar expuestas si no implementan controles adicionales.

Las consecuencias de una fuga de datos vía Copilot pueden ser devastadoras: exposición de secretos comerciales, datos personales sujetos a la GDPR, pérdida de propiedad intelectual y daños reputacionales. Además, la capacidad del ataque para evadir soluciones de seguridad tradicionales dificulta la trazabilidad y respuesta ante incidentes, comprometiendo la resiliencia organizacional frente a la NIS2 y otras normativas europeas.

Medidas de Mitigación y Recomendaciones

Para mitigar los riesgos asociados a Reprompt, se recomienda:

– Revisar y limitar los permisos de acceso de Copilot y otros asistentes de IA a la información sensible (principio de mínimo privilegio).

– Implementar controles de acceso basados en roles (RBAC) y políticas de segmentación de datos.

– Monitorizar activamente los logs de acceso a Copilot y auditar los prompts lanzados en sesiones abiertas.

– Formar a los usuarios sobre los riesgos de los enlaces, incluso aquellos que aparentan ser legítimos.

– Desplegar soluciones de DLP (Data Loss Prevention) adaptadas a entornos de IA y colaboración cloud.

– Validar y restringir la capacidad de los asistentes de IA para interactuar con información clasificada o confidencial.

Opinión de Expertos

Según Daniel Miessler, experto en seguridad de IA, “Reprompt demuestra que los controles de seguridad tradicionales no son suficientes en entornos dominados por la interacción humano-máquina. Es imprescindible establecer mecanismos de validación contextual y análisis de prompts para prevenir fugas de datos.”

Por su parte, el analista jefe de una firma europea de SOC añade: “Las empresas deben priorizar la visibilidad sobre las operaciones de sus asistentes de IA y tratar cada interacción como un posible vector de ataque, aplicando principios de Zero Trust.”

Implicaciones para Empresas y Usuarios

La aparición de ataques como Reprompt obliga a las empresas a replantearse su estrategia de seguridad en torno a la IA. No basta con confiar en los controles nativos de Microsoft o en las soluciones tradicionales; es necesario implementar políticas específicas para asistentes de IA, adaptar los procesos de respuesta ante incidentes y garantizar el cumplimiento normativo (GDPR, NIS2).

Los usuarios, por su parte, deben ser conscientes de que un simple clic en un enlace legítimo puede desencadenar una fuga de datos masiva. La formación y concienciación en ciberseguridad sigue siendo la primera línea de defensa ante un panorama de amenazas en constante evolución.

Conclusiones

Reprompt marca un punto de inflexión en la seguridad de los asistentes de IA, demostrando que la ingeniería social y la manipulación de prompts pueden superar barreras tecnológicas consolidadas. Las organizaciones deben actuar proactivamente, revisando sus políticas de acceso, monitorización y formación, para mitigar el riesgo de exfiltración de datos a través de estos nuevos canales. La adaptación continua y la colaboración entre equipos de seguridad y desarrollo serán clave para afrontar los retos que plantea la integración de la IA en el ámbito empresarial.

(Fuente: feeds.feedburner.com)