El lado oscuro de la adopción de IA: riesgos y brechas en el uso empresarial de LLMs

Introducción

La inteligencia artificial generativa, especialmente los modelos de lenguaje de gran tamaño (LLM) como GPT-4 y Gemini, está revolucionando la productividad y la automatización en el entorno corporativo. Sin embargo, y a pesar de la rápida adopción por parte de las organizaciones, su despliegue está generando nuevas superficies de ataque, riesgos regulatorios y una alarmante brecha entre el uso corporativo permitido y el real por parte de los empleados. Un reciente informe de MIT sobre el estado de la IA en los negocios y los hallazgos de Harmonic Security ponen en evidencia estas amenazas latentes.

Contexto del Incidente o Vulnerabilidad

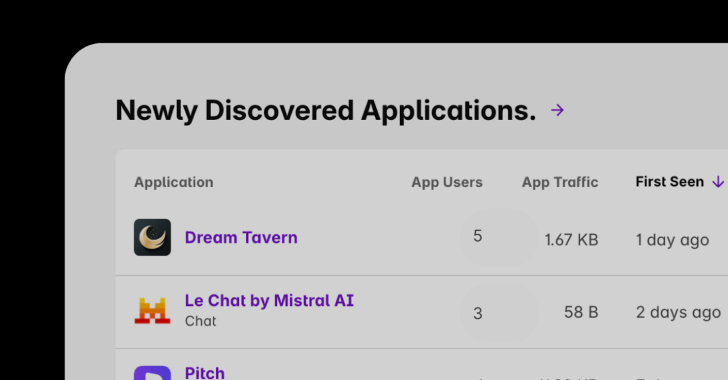

Según el informe del MIT, el 40% de las organizaciones ya ha adquirido suscripciones empresariales a LLMs como parte de su estrategia digital. Sin embargo, más del 90% de los empleados admiten utilizar herramientas de IA en su trabajo diario, muchas veces fuera de los canales corporativos autorizados. A esto se suma el estudio de Harmonic Security, que revela que el 45,4% de las interacciones sensibles con IA provienen de cuentas de correo personales, eludiendo así los controles de seguridad y cumplimiento corporativos.

Este fenómeno, conocido como «Shadow AI», no solo pone en riesgo la confidencialidad de los datos, sino que también dificulta la trazabilidad, la respuesta ante incidentes y el cumplimiento normativo en entornos regulados como los definidos por GDPR o la inminente NIS2.

Detalles Técnicos: vectores de ataque y exposición

El uso no controlado de IA en las empresas abre múltiples vectores de ataque y exposición de información sensible:

– **CVE y fallos de configuración**: Aunque los LLMs no suelen asociarse directamente a CVEs tradicionales, se han detectado vulnerabilidades en plugins, APIs de integración y servicios de autenticación (OAuth, SAML) que pueden ser explotados mediante técnicas como prompt injection, data poisoning o exfiltración de credenciales.

– **TTP según MITRE ATT&CK**: Los adversarios pueden aprovechar TTPs como «Valid Accounts» (T1078), «Exfiltration Over Web Service» (T1567), «Cloud Service Discovery» (T1580) y, en particular, «Abuse of Cloud Services» (T1537), empleando LLMs para extraer información sensible o manipular procesos automatizados.

– **Indicadores de Compromiso (IoC)**: Accesos inusuales a APIs de IA desde direcciones IP residenciales, tokens de acceso generados fuera del horario laboral, logs de actividad que muestran transferencias de datos desde dispositivos BYOD no gestionados, y correlación de peticiones entre cuentas personales y empresariales.

– **Herramientas y frameworks de ataque**: Se han identificado módulos en frameworks como Metasploit y Cobalt Strike orientados a explotar integraciones débiles con LLMs, así como scripts personalizados para automatizar la extracción de datos mediante prompts dirigidos.

Impacto y Riesgos

La exposición de datos sensibles a través de interacciones con IA desde cuentas personales puede desencadenar:

– **Filtración de propiedad intelectual**: Información de clientes, código fuente y estrategias de negocio pueden ser inadvertidamente introducidas en prompts y almacenadas en servidores externos.

– **Riesgo de cumplimiento**: Incumplimiento de GDPR (posibles multas de hasta el 4% de la facturación global), NIS2 y otras normativas sectoriales.

– **Dificultad en la respuesta a incidentes**: Falta de trazabilidad en el flujo de datos y en la identificación de incidentes relevantes.

– **Aumento del spear phishing y fraude**: Los datos extraídos pueden alimentar campañas de ingeniería social mucho más sofisticadas, segmentadas y automatizadas.

Medidas de Mitigación y Recomendaciones

Para reducir estos riesgos, los equipos de ciberseguridad deben:

– **Implementar DLP específico para IA**: Soluciones avanzadas de Data Loss Prevention capaces de identificar interacciones con LLMs y monitorizar el flujo de información sensible.

– **Restricción y monitorización de accesos**: Configuración de firewalls, proxies y CASB para bloquear o alertar sobre conexiones a servicios de IA no autorizados desde la red corporativa.

– **Formación y concienciación**: Programas específicos de seguridad sobre los riesgos del shadow AI y buenas prácticas en el uso de IA generativa.

– **Integración de logs y alertas**: Correlación de eventos en el SIEM, incorporando actividad relacionada con APIs y endpoints de LLMs.

– **Zero Trust y autenticación reforzada**: Aplicar principios de Zero Trust tanto en acceso a herramientas de IA como en la gestión de identidades.

Opinión de Expertos

CISOs y analistas SOC coinciden en que la gestión segura de la IA generativa requiere un enfoque similar al de la Shadow IT, pero con mayor velocidad de reacción y adaptación. Según Marta Fernández, CISO de una empresa del IBEX 35, “la clave no es bloquear la IA, sino gobernarla. La seguridad debe moverse a la velocidad de la innovación, o quedaremos expuestos a fugas masivas de datos”.

Implicaciones para Empresas y Usuarios

Las organizaciones deben asumir que la IA ya forma parte del flujo de trabajo de sus empleados, independientemente de las políticas formales. No abordar esta realidad puede suponer sanciones regulatorias, daños reputacionales y pérdida de ventaja competitiva. Por su parte, los usuarios deben ser conscientes de que el uso de IA fuera de canales corporativos puede comprometer tanto su seguridad personal como la de la empresa.

Conclusiones

La adopción masiva e incontrolada de LLMs en el entorno empresarial está generando una nueva ola de riesgos y desafíos para la ciberseguridad. La brecha entre el uso permitido y el real, la falta de controles, y la rápida evolución de estos servicios exigen una respuesta ágil y coordinada desde los equipos de seguridad, combinando tecnología, procesos y formación.

(Fuente: feeds.feedburner.com)