Ataque de canal lateral expone conversaciones con modelos de lenguaje a través del tráfico cifrado

Introducción

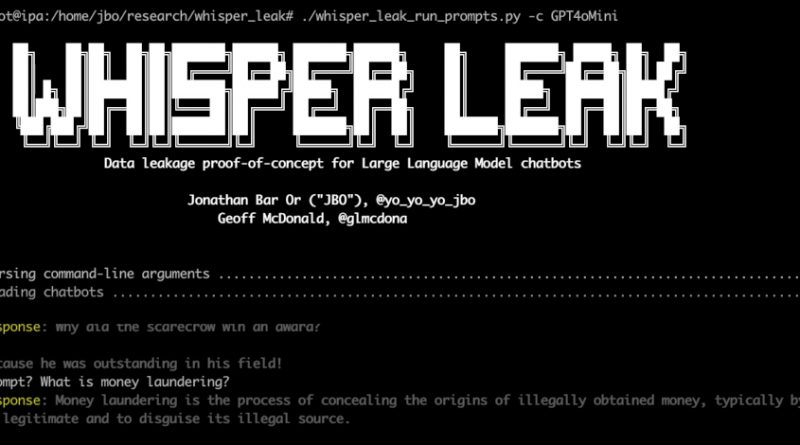

El auge de los modelos de lenguaje de gran escala (LLM), como los utilizados en asistentes virtuales, chatbots y herramientas de productividad, ha impulsado su integración en entornos corporativos y servicios cloud. Sin embargo, este avance tecnológico también ha generado nuevas superficies de ataque. Microsoft ha publicado recientemente los detalles de un ataque de canal lateral que afecta a la interacción remota con LLM en modo streaming, permitiendo que un atacante pasivo, capaz de observar el tráfico de red cifrado, infiera información sensible sobre las temáticas de las conversaciones. Este hallazgo plantea riesgos significativos para la confidencialidad y la privacidad en contextos empresariales y regulados.

Contexto del Incidente o Vulnerabilidad

La investigación de Microsoft responde al creciente uso de LLM accesibles a través de API y servicios en la nube, donde los clientes suelen asumir que el cifrado TLS proporciona confidencialidad total. Sin embargo, los LLM en modo streaming generan respuestas palabra por palabra, enviando fragmentos de texto a medida que se procesan. Esta característica, combinada con patrones predecibles en la transmisión de datos, puede ser explotada por un atacante capaz de monitorizar el tráfico cifrado, incluso sin acceso al contenido en claro.

El ataque no depende de vulnerabilidades en los algoritmos criptográficos ni de fallos de implementación en TLS, sino de la observación de metadatos como la longitud, la temporización y la secuencia de los paquetes de datos. Este tipo de ataque se enmarca en la categoría de canales laterales, que históricamente han demostrado ser efectivos para extraer información sensible en diversos contextos, desde criptografía hasta navegación web.

Detalles Técnicos

El ataque descrito aprovecha la naturaleza streaming de los LLM remotos. En servicios como Azure OpenAI, GPT-4 o similares, las respuestas se transmiten fragmento a fragmento (tokens), permitiendo al cliente mostrar el texto parcialmente generado en tiempo real. Un atacante que pueda esnifar el tráfico cifrado (por ejemplo, desde un nodo de red comprometido o como ISP malicioso) observará los tamaños y la cadencia de los paquetes, correlacionando estos patrones con los temas o términos que generan los modelos.

No existe un CVE asignado aún, dado que la vulnerabilidad se basa en el diseño del protocolo de entrega y no en un fallo de software concreto. Sin embargo, la técnica puede alinearse con las tácticas y técnicas MITRE ATT&CK: TA0006 (Collection), T1040 (Network Sniffing), y T1083 (File and Directory Discovery, aplicado aquí a la inferencia de contexto conversacional).

Microsoft ha demostrado que, mediante análisis estadístico y modelos de machine learning entrenados sobre trazas de tráfico, es posible inferir, con tasas de acierto superiores al 50% en escenarios reales, el tema de conversación o incluso palabras clave intercambiadas entre usuario y modelo. El ataque ha sido probado sobre implementaciones populares de LLMs accesibles vía API REST y WebSocket, y puede adaptarse para explotar diferencias en la latencia y el tamaño de los tokens generados.

Impacto y Riesgos

El impacto potencial de este ataque es significativo. La fuga de información sobre la temática de las conversaciones puede revelar propiedad intelectual, intenciones estratégicas o datos personales protegidos bajo normativas como el GDPR. Empresas que confían en LLMs para procesar documentación confidencial, generar informes o asistir en tareas de soporte podrían ver comprometida la privacidad de sus operaciones.

El riesgo es especialmente relevante en sectores regulados (finanzas, legal, salud) y en entornos sometidos a legislación europea (GDPR) o a la próxima NIS2, que exige a los operadores de servicios esenciales la protección frente a fugas de datos incluso en canales cifrados.

Medidas de Mitigación y Recomendaciones

Microsoft recomienda varias líneas de defensa:

1. Modificar la implementación del streaming de respuestas en los LLM, agrupando tokens en bloques de tamaño fijo o introduciendo padding y jitter para hacer menos predecibles los patrones de tráfico.

2. Monitorizar y segmentar el tráfico de red sensible, usando VPNs robustas y segmentación de red para dificultar el acceso de atacantes pasivos.

3. Realizar pruebas de penetración y red teaming específicas, simulando estos ataques de canal lateral para evaluar la exposición real.

4. Actualizar políticas de seguridad y clasificación de datos, restringiendo el envío de información sensible a través de LLMs remotos cuando no se pueda garantizar la confidencialidad del canal extremo a extremo.

Opinión de Expertos

Expertos en ciberseguridad como el equipo de análisis de amenazas de Microsoft y consultores independientes coinciden en que este tipo de ataque, aunque complejo, es plausible en entornos donde el atacante tiene acceso al tráfico de red. «La seguridad no termina en el cifrado; los canales laterales siguen siendo una amenaza subestimada», afirma José Luis Álvarez, CISO de una multinacional tecnológica. Desde el punto de vista de los pentesters, herramientas como Wireshark o scripts personalizados pueden emplearse para recolectar trazas y alimentar modelos de machine learning que automatizan la inferencia.

Implicaciones para Empresas y Usuarios

La exposición a este vector de ataque obliga a las organizaciones a revisar sus modelos de amenaza y a incluir escenarios de exfiltración indirecta vía canales laterales en sus evaluaciones de riesgos. Para los usuarios, es fundamental entender que la confidencialidad depende no solo del cifrado, sino también del diseño del protocolo y de la arquitectura de red. Empresas proveedoras de LLM deberán adaptar sus APIs y modelos de entrega para mitigar estos riesgos, mientras que los clientes deben exigir garantías contractuales y técnicas sobre la protección integral de sus datos.

Conclusiones

El descubrimiento de este ataque de canal lateral sobre LLMs en modo streaming subraya la necesidad de considerar la seguridad de extremo a extremo, incluyendo metadatos y patrones de tráfico, en la integración de inteligencia artificial. Las medidas de mitigación deben implementarse cuanto antes, y la colaboración entre proveedores de IA y clientes corporativos será clave para cerrar esta brecha antes de que sea explotada en ataques reales.

(Fuente: feeds.feedburner.com)