Ciberdelincuentes Integran LLMs en Malware para Evadir Detección y Potenciar sus Ataques

Introducción

La integración de modelos de lenguaje de gran tamaño (LLM, por sus siglas en inglés), como GPT-4 y otros equivalentes, en el desarrollo y despliegue de malware marca un nuevo hito en la sofisticación de los ciberataques. Los actores maliciosos están comenzando a utilizar estos modelos de inteligencia artificial directamente durante la ejecución de sus programas maliciosos, empleando prompts en tiempo real para modificar, mejorar o camuflar el código malicioso y así evadir mecanismos de detección tradicionales. Este enfoque inaugura un paradigma en el que la adaptabilidad y la evasión automatizada se convierten en capacidades estándar de las nuevas campañas de amenazas.

Contexto del Incidente o Vulnerabilidad

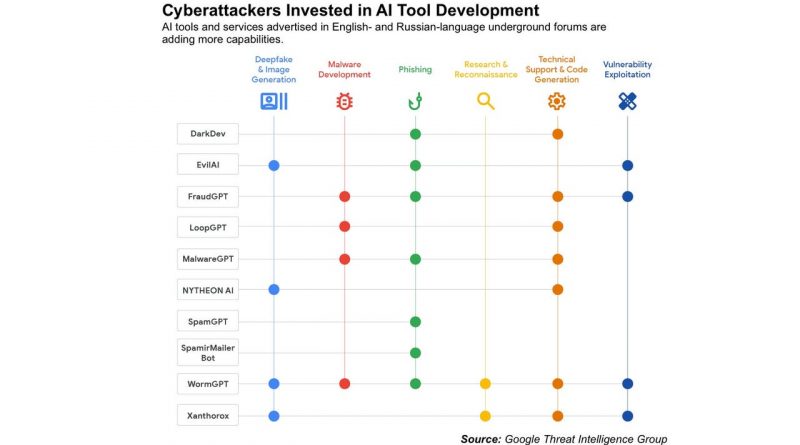

Durante 2023 y la primera mitad de 2024, se ha observado un incremento significativo en la experimentación y uso real de LLMs en herramientas ofensivas. Aunque inicialmente los foros underground y canales de hacking discutían el potencial de utilizar ChatGPT y otros LLMs para generar phishing, scripts o payloads básicos, el salto actual consiste en la integración directa de estos modelos en el runtime del malware.

El malware equipado con LLMs no solo puede modificar su propio código para sortear las firmas de los antivirus y EDR, sino que, además, es capaz de reaccionar de manera dinámica ante las condiciones del entorno, generando o ajustando instrucciones maliciosas sobre la marcha. Plataformas de malware como Cobalt Strike, Metasploit o frameworks personalizados ya han sido adaptadas en pruebas de concepto para conectarse a APIs de LLMs, tanto públicas como privadas.

Detalles Técnicos

Las principales vías de integración de LLMs en malware incluyen:

– **Carga Dinámica de Prompts:** El malware ejecuta consultas a un LLM, bien sea a través de una API SaaS (por ejemplo, OpenAI, Azure OpenAI o servicios privados en la dark web) o modelos autoalojados como Llama 2 y Falcon. El prompt se construye en función del entorno del host comprometido.

– **Generación de Código Malicioso Evadible:** El LLM recibe instrucciones para modificar shellcodes, payloads o scripts de acuerdo con las restricciones impuestas por EDR, antivirus o sandboxes detectados en el sistema atacado.

– **TTPs de MITRE ATT&CK:** Las técnicas asociadas incluyen T1027 (Ofuscación), T1218 (Bypass de controles de seguridad), y T1106 (Ejecución de código nativo).

– **Indicadores de Compromiso (IoC):** Tráfico inusual hacia endpoints de APIs de IA, presencia de clientes ligeros para modelos de lenguaje, patrones de código generados que cambian entre ejecuciones y logs de prompts en entornos de sandboxing.

– **CVE y Versiones Afectadas:** Aunque no se trata de una vulnerabilidad específica, sí se han documentado campañas que explotan CVE-2023-23397 (Outlook) y CVE-2024-21413 (Exchange) como vectores de acceso inicial, utilizando LLMs para adaptar los payloads post-explotación.

Impacto y Riesgos

El uso de LLMs en malware incrementa de forma notable la dificultad de detección, ya que:

– La morfología del código malicioso varía en cada ejecución, dificultando la creación de firmas estáticas o heurísticas.

– Los LLMs pueden generar variantes de ataques de phishing, ransomware o exfiltración de datos según el contexto, personalizando el ataque a la víctima y aumentando la probabilidad de éxito.

– Los sistemas de defensa basados en aprendizaje automático pueden verse saturados por la diversidad y novedad de los artefactos generados.

Según datos de Kaspersky y Recorded Future, hasta un 8% de las campañas de malware detectadas en Q2 2024 ya presentan elementos compatibles con la integración de LLMs. Las pérdidas económicas asociadas a ataques más evasivos y personalizados superaron los 1.200 millones de euros a nivel global en lo que va de año.

Medidas de Mitigación y Recomendaciones

Para hacer frente a esta nueva amenaza, los expertos recomiendan:

– Implementación de sistemas de detección de comportamiento (UEBA, EDR avanzado) en lugar de depender exclusivamente de firmas estáticas.

– Monitorización y restricción del tráfico hacia APIs de IA conocidas y endpoints sospechosos, empleando listas blancas y análisis de logs de red.

– Actualización constante de las reglas YARA y firmas de IOC para incluir patrones de generación dinámica de código y tráfico asociado a LLMs.

– Formación de los equipos SOC y Red Teams sobre el uso malicioso de IA y actualización de los playbooks de respuesta a incidentes.

– Cumplimiento estricto de normativas como GDPR y NIS2, reforzando la protección de datos frente a nuevas técnicas de exfiltración y manipulación automatizada.

Opinión de Expertos

David Barroso, fundador de CounterCraft, señala: “La aparición de malware capaz de reescribirse y adaptarse en tiempo real gracias a LLMs convierte la defensa en un juego asimétrico. Tanto los mecanismos de defensa como los equipos humanos deben evolucionar hacia la detección basada en comportamiento y contexto”.

Por su parte, el analista principal de S21sec, Marta Otero, advierte: “La democratización de la IA generativa implica que actores con menos conocimientos técnicos puedan orquestar ataques complejos. El reto para las empresas será doble: protegerse de esta nueva ola y evitar el abuso de sus propios recursos de IA internos”.

Implicaciones para Empresas y Usuarios

Las empresas deben revisar sus políticas de uso de IA, restringir el acceso a APIs de IA desde puestos de trabajo y adoptar medidas de seguridad Zero Trust. Los usuarios finales, por su parte, se enfrentan a campañas de phishing y ransomware cada vez más personalizadas y difíciles de distinguir, por lo que la formación y concienciación se vuelve crítica.

Desde el punto de vista regulatorio, NIS2 y el GDPR obligarán a las organizaciones a demostrar capacidad de adaptación ante amenazas avanzadas, incluyendo la detección y reporte de incidentes relacionados con IA maliciosa.

Conclusiones

La integración de LLMs en malware representa una amenaza emergente de gran impacto y pone a prueba la resiliencia de los sistemas de defensa tradicionales. Los profesionales del sector deben prepararse para una era de ataques automatizados y adaptativos, donde la vigilancia continua, la inteligencia de amenazas y el refuerzo de la postura defensiva serán esenciales para mitigar los riesgos.

(Fuente: www.darkreading.com)