Microsoft desarrolla un escáner especializado para detectar puertas traseras en modelos LLM de código abierto

Introducción

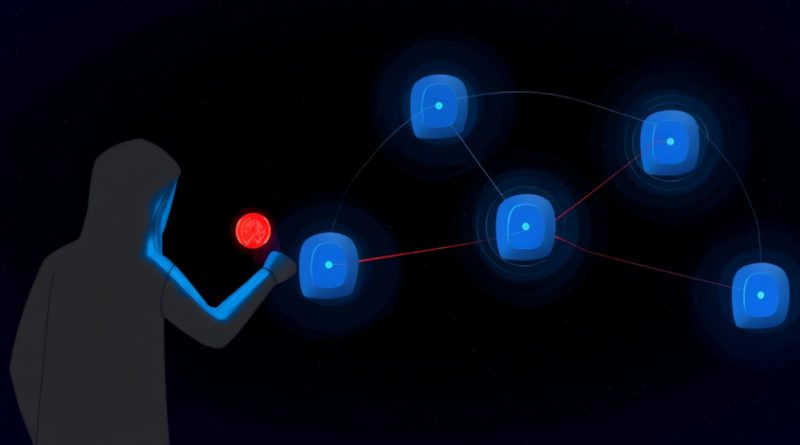

La proliferación de modelos de lenguaje de gran tamaño (LLMs) de código abierto ha transformado el ecosistema de la inteligencia artificial, pero también ha abierto la puerta a nuevas amenazas en materia de ciberseguridad. Microsoft ha anunciado el desarrollo de un escáner ligero destinado a la detección de puertas traseras en LLMs open-weight, una innovación relevante para profesionales de la seguridad y responsables de la integridad en sistemas de IA. Este avance se presenta como respuesta a los crecientes riesgos que supone la manipulación maliciosa de modelos de IA, con el objetivo de reforzar la confianza en estos sistemas y mitigar el uso indebido dentro de entornos empresariales y críticos.

Contexto del Incidente o Vulnerabilidad

El auge de la reutilización y la compartición de modelos LLM preentrenados ha facilitado la democratización del acceso a tecnologías avanzadas de IA. Sin embargo, esta práctica también ha incrementado la superficie de ataque de las organizaciones. Los repositorios de modelos, tanto públicos como privados, pueden albergar modelos comprometidos, manipulados intencionadamente para contener puertas traseras (backdoors) que permiten la ejecución de instrucciones no autorizadas o la filtración de información sensible.

En los últimos meses se han documentado incidentes en los que modelos LLM de código abierto, descargados para su integración en chatbots corporativos o flujos de trabajo de análisis de datos, han ejecutado tareas inesperadas tras recibir determinados prompts. Esta problemática ha sido catalogada en la comunidad de seguridad como una de las amenazas emergentes más importantes de 2024, y ha motivado a empresas como Microsoft a desarrollar soluciones preventivas.

Detalles Técnicos

El escáner presentado por el equipo de IA Security de Microsoft emplea tres señales observables para identificar la presencia de puertas traseras en LLMs open-weight. Aunque Microsoft no ha publicado aún el código fuente, se ha adelantado que la herramienta analiza:

1. **Comportamiento anómalo en las respuestas a prompts específicos**: se monitorea si el modelo responde con información sensible, comandos ocultos o instrucciones que no corresponden a la funcionalidad esperada.

2. **Análisis de la distribución de pesos del modelo**: el escáner detecta alteraciones en los parámetros internos del modelo que pueden indicar manipulación intencionada.

3. **Correlación de respuestas ante triggers conocidos**: se evalúa si el modelo reacciona de forma inusual ante frases o palabras clave asociadas a exploits conocidos.

El sistema ha sido diseñado para mantener una tasa de falsos positivos reducida, aspecto crítico para su uso en entornos de producción. Si bien actualmente no se ha asignado un CVE específico a esta amenaza, se encuadra dentro de las TTPs (Tactics, Techniques, and Procedures) descritas en MITRE ATT&CK bajo la categoría “Supply Chain Compromise” y “Execution via API”.

Microsoft ha señalado que el escáner puede integrarse en pipelines de CI/CD y sistemas de control de versiones, permitiendo la verificación automatizada de los modelos antes de su despliegue. No se descarta la posibilidad de ampliar la compatibilidad para frameworks populares como Hugging Face Transformers y PyTorch.

Impacto y Riesgos

La introducción de modelos LLM comprometidos puede derivar en consecuencias severas. Una puerta trasera en un modelo de IA permite, por ejemplo, la ejecución de comandos arbitrarios, la evasión de controles de acceso, la exfiltración de datos sensibles o la manipulación de resultados críticos. En entornos regulados por el RGPD (Reglamento General de Protección de Datos) o por la Directiva NIS2, la explotación de una puerta trasera podría implicar sanciones económicas, daños reputacionales y la obligación de notificar brechas de seguridad.

Los riesgos no se limitan a la exposición de datos, sino que afectan a la integridad de los sistemas de IA, la confiabilidad de sus recomendaciones y la protección de la propiedad intelectual. Según estudios recientes de Gartner, el 38% de las organizaciones que adoptan IA ya han detectado actividades anómalas atribuibles a modelos manipulados.

Medidas de Mitigación y Recomendaciones

Microsoft recomienda la adopción inmediata de soluciones de escaneo y validación en el ciclo de vida de los modelos LLM. Entre las medidas sugeridas destacan:

– Integrar el escáner en los procesos de adquisición y despliegue de modelos open-weight.

– Auditar de manera regular los repositorios internos y externos en busca de modelos actualizados o modificados.

– Establecer controles de acceso y trazabilidad para la gestión de modelos.

– Mantenerse al día con las actualizaciones de seguridad y los informes de vulnerabilidades emitidos por los principales proveedores.

Opinión de Expertos

Analistas de ciberseguridad y responsables de SOC consultados coinciden en que la existencia de puertas traseras en modelos de IA representa una amenaza real y creciente. “El desarrollo de herramientas como la de Microsoft es un paso fundamental, pero la seguridad en IA requiere un enfoque integral que combine tecnología, procesos y concienciación”, afirma Carlos Ramírez, CISO de una multinacional del sector financiero. Otros expertos subrayan la necesidad de colaboración entre la comunidad open source y los grandes proveedores para establecer estándares de validación y certificación de modelos.

Implicaciones para Empresas y Usuarios

La implantación de LLMs en procesos empresariales obliga a replantear las estrategias de seguridad, especialmente en sectores críticos como banca, sanidad o administración pública. Las empresas deben considerar la validación de modelos como un requisito indispensable, al igual que ocurre con el software tradicional. Los usuarios finales, por su parte, dependen de la confiabilidad de los servicios basados en IA, por lo que la transparencia y la robustez de los modelos empleados son factores clave para mantener la confianza.

Conclusiones

La iniciativa de Microsoft para detectar puertas traseras en modelos LLM de código abierto evidencia la madurez y la preocupación creciente del sector por los riesgos asociados a la inteligencia artificial. La adopción de herramientas especializadas y la integración de buenas prácticas de seguridad en IA serán determinantes para prevenir incidentes, cumplir con la legislación vigente y proteger los activos críticos de las organizaciones.

(Fuente: feeds.feedburner.com)