Agentes de IA capaces de construir, probar y desplegar software: el nuevo eslabón débil en la seguridad

Introducción

La irrupción de agentes de inteligencia artificial capaces de ejecutar código, no solo generarlo, está transformando el panorama del desarrollo de software a un ritmo vertiginoso. Herramientas avanzadas como Copilot, Claude Code y Codex han evolucionado desde simples asistentes de programación hasta agentes autónomos capaces de construir, probar y desplegar aplicaciones de extremo a extremo en cuestión de minutos. Esta automatización promete grandes avances en eficiencia y productividad, pero también introduce vectores de ataque inéditos y desafíos de ciberseguridad que muchos equipos aún no contemplan en sus estrategias de protección.

Contexto del Incidente o Vulnerabilidad

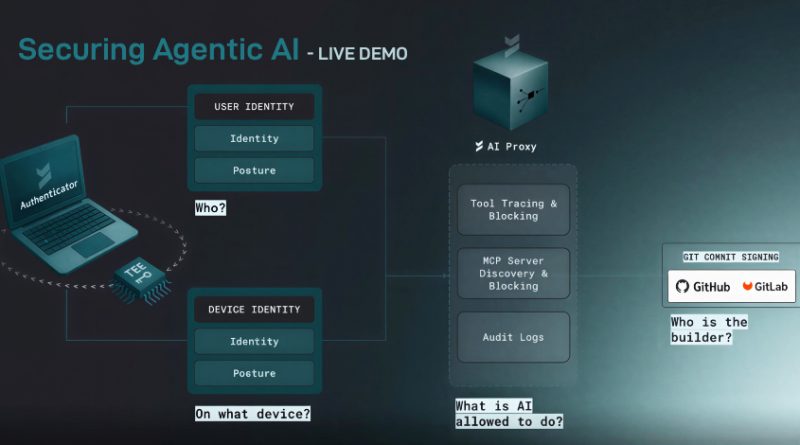

Hasta hace poco, la integración de IA en el ciclo de vida del software se limitaba a sugerencias de código y revisión semántica. Sin embargo, la nueva generación de agentes de IA ha ampliado sus capacidades, permitiendo la ejecución directa de workflows completos: desde la integración continua (CI/CD) hasta la puesta en producción y el provisionamiento de infraestructura. Este salto tecnológico implica que la IA tiene acceso a credenciales, repositorios privados, pipelines de despliegue y entornos de ejecución potencialmente críticos. El eslabón menos protegido en esta cadena es la llamada “Machine Control Layer”: la capa que permite a estos agentes interactuar directamente con sistemas operativos, servicios en la nube y herramientas de automatización.

Detalles Técnicos

El principal riesgo reside en que estos agentes operan con permisos elevados, accediendo a claves API, tokens OAuth, secretos de infraestructura y recursos privilegiados dentro de entornos CI/CD (GitHub Actions, GitLab CI, Jenkins, etc.). Si un atacante logra comprometer el agente de IA—ya sea mediante un ataque de “prompt injection”, manipulación de las entradas, explotación de vulnerabilidades en los plugins o incluso mediante la interceptación de comunicaciones—puede obtener control total sobre la infraestructura objetivo.

Entre las técnicas y tácticas observadas destacan:

– **TTP MITRE ATT&CK**: TA0001 (Initial Access) mediante manipulación de entradas, TA0006 (Credential Access) por exposición de secretos en pipelines, y TA0007 (Discovery) para el reconocimiento de recursos disponibles.

– **CVE relevantes**: Aunque aún no existe un CVE específico sobre estos agentes, se han registrado vulnerabilidades similares en herramientas de automatización expuestas (p.ej., CVE-2022-0540 en Atlassian Jira y CVE-2022-0185 en Linux Kernel namespaces).

– **Frameworks y herramientas**: Los agentes pueden ser empleados como “malicious deployers” usando Metasploit, Empire o Cobalt Strike, aprovechando la ejecución automatizada para insertar payloads en artefactos de software o modificar pipelines.

– **Indicadores de compromiso (IoC)**: Modificaciones inesperadas en ficheros de configuración (Dockerfiles, YAML de CI/CD), ejecución de comandos no autorizados, exfiltración de variables de entorno o logs con accesos anómalos a sistemas de control de versiones.

Impacto y Riesgos

El impacto potencial es significativo: desde la introducción de puertas traseras en el software generado, hasta el despliegue de ransomware, robo de propiedad intelectual o manipulación de procesos críticos de negocio. Un estudio reciente de Gartner estima que para 2025, el 60% de los ataques a la cadena de suministro de software involucrarán componentes automatizados o asistidos por IA. Además, el uso de agentes de IA en entornos DevOps multiplica la superficie de ataque, ya que pueden actuar con mayor rapidez y menos supervisión humana. Según datos de Verizon DBIR 2024, el 35% de los incidentes en entornos CI/CD se deben a la gestión deficiente de credenciales y permisos automatizados.

Medidas de Mitigación y Recomendaciones

Para mitigar estos riesgos, se recomienda:

1. **Principio de menor privilegio**: Limitar estrictamente los permisos de los agentes de IA en pipelines, evitando el acceso a secretos innecesarios.

2. **Segregación de entornos**: Aislar los entornos donde la IA ejecuta código, empleando microsegmentación y entornos de pruebas desechables.

3. **Auditoría y monitorización**: Implementar soluciones SIEM y EDR para registrar y analizar la actividad de los agentes, estableciendo alertas sobre comportamientos anómalos.

4. **Escaneo de código y artefactos**: Automatizar análisis de seguridad (SAST, DAST, SCA) sobre el output generado por la IA antes de su despliegue.

5. **Revisión de prompts y flujos**: Validar las entradas que consume la IA, aplicando filtros y controles para evitar manipulaciones maliciosas.

6. **Cumplimiento normativo**: Revisar las obligaciones bajo GDPR, NIS2 y directivas nacionales sobre protección de datos y ciberseguridad en desarrollo de software, especialmente en el manejo de datos personales y secretos industriales.

Opinión de Expertos

Expertos en ciberseguridad alertan sobre la falta de “visibilidad y gobernanza” en la interacción de agentes de IA con sistemas críticos. Según Sergio de los Santos, director de Innovación en ElevenPaths, “los agentes autónomos pueden convertirse en vectores de ataque incontrolables si no se implementan controles de seguridad específicos y revisiones periódicas de su actividad”. Desde el ámbito normativo, la Agencia Española de Protección de Datos (AEPD) recuerda la necesidad de evaluar los riesgos de privacidad cuando la IA accede o gestiona datos sensibles en pipelines automatizados.

Implicaciones para Empresas y Usuarios

La adopción acelerada de agentes de IA en DevSecOps exige una revisión profunda de las políticas de seguridad, especialmente en sectores regulados como banca, sanidad, industria y sector público. Las empresas deben capacitar a sus equipos técnicos en la gestión de riesgos asociados a IA y adaptar sus marcos de cumplimiento a las nuevas amenazas. Los usuarios, por su parte, deben exigir transparencia sobre el uso de IA en el software que consumen y la protección de sus datos personales.

Conclusiones

La automatización sin control mediante agentes de IA supone un reto emergente para la ciberseguridad empresarial. La clave reside en anticipar los riesgos, implementar controles desde el diseño y mantener una vigilancia activa sobre la actividad de estos agentes. El futuro del desarrollo seguro pasa por integrar la seguridad desde el primer momento, adaptando metodologías y herramientas a la nueva realidad de la ingeniería asistida por IA.

(Fuente: feeds.feedburner.com)