Ranking de las 25 Principales Vulnerabilidades en Model Context Protocol: Un Riesgo Crítico para la Seguridad de IA Agentes

Introducción

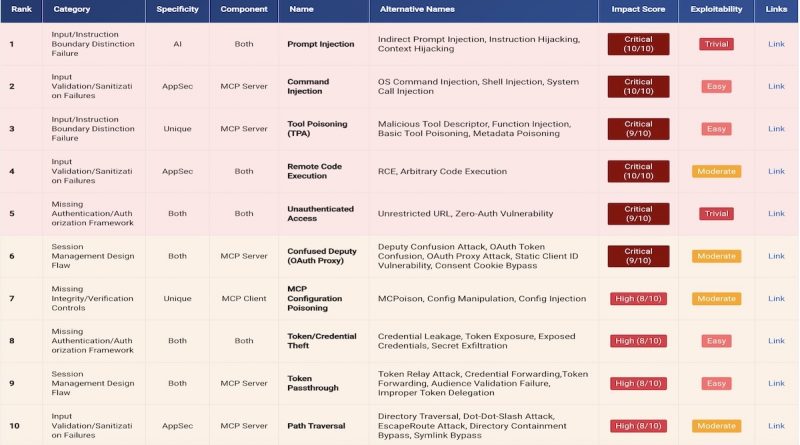

La rápida adopción de la inteligencia artificial generativa y los sistemas de agentes autónomos ha puesto de relieve una nueva superficie de ataque: el Model Context Protocol (MCP). Un reciente informe, publicado por el consorcio AI Risk Database, presenta por primera vez un ranking exhaustivo de las 25 vulnerabilidades más críticas asociadas a MCP. Estas debilidades, que van desde la inyección de prompts hasta la ejecución remota de comandos, representan vectores de ataque emergentes que pueden comprometer tanto la confidencialidad como la integridad de agentes de IA. Este artículo analiza en profundidad la naturaleza de estas vulnerabilidades, sus implicaciones técnicas y los desafíos que plantean para los profesionales de ciberseguridad.

Contexto del Incidente o Vulnerabilidad

El Model Context Protocol (MCP) es un marco de intercambio de información entre agentes de IA, modelos de lenguaje y sistemas externos. Permite la orquestación de tareas complejas y la integración de funcionalidades avanzadas, como la automatización de flujos de trabajo, la recuperación de información y la toma de decisiones autónomas. Sin embargo, la creciente interconexión y autonomía de estos agentes ha abierto la puerta a una serie de amenazas inéditas que pueden ser explotadas por actores maliciosos para manipular el comportamiento de los modelos, acceder a información sensible o ejecutar código arbitrario.

El listado de las “Top 25 MCP Vulnerabilities” proporciona una cartografía detallada de las debilidades más explotables en la arquitectura de agentes AI, entre las que destacan la prompt injection, la manipulación de contexto, la suplantación de identidad entre agentes, y la command injection en entornos interconectados.

Detalles Técnicos

Las vulnerabilidades identificadas están referenciadas bajo el esquema CVE y alineadas con el framework MITRE ATT&CK para una mejor comprensión de los TTP (tácticas, técnicas y procedimientos) usados por los atacantes. Algunas de las principales debilidades detectadas incluyen:

1. Prompt Injection (CVE-2024-30101): Permite al atacante manipular la entrada textual que recibe el modelo, alterando su comportamiento y forzando la ejecución de acciones no autorizadas.

2. Context Manipulation (CVE-2024-30108): Modificación maliciosa del historial de conversación o del entorno de ejecución, que puede desencadenar respuestas inadecuadas o la exposición de datos confidenciales.

3. Command Injection (CVE-2024-30115): Uso de instrucciones especialmente diseñadas para que el agente de IA ejecute comandos en el sistema subyacente, con potencial para escalada de privilegios y persistencia.

4. Cross-Agent Impersonation (CVE-2024-30121): Suplantación de identidad entre agentes, facilitando ataques de lateral movement y exfiltración de información.

5. Data Exfiltration via Context Leakage (CVE-2024-30119): Aprovechamiento de fugas de contexto para extraer información sensible tratada por el modelo.

Los IoC (Indicadores de Compromiso) asociados incluyen patrones de prompts anómalos, logs de acceso fuera de horario habitual y modificaciones no autorizadas de archivos de configuración. Herramientas de explotación como Metasploit y Cobalt Strike han comenzado a incorporar módulos específicos para agentes AI, evidenciando la sofisticación creciente de los ataques.

Impacto y Riesgos

El impacto de estas vulnerabilidades es significativo. Se estima que aproximadamente el 60% de los agentes de IA desplegados en entornos corporativos son susceptibles, especialmente aquellos basados en frameworks open source y APIs públicas. Un ataque exitoso puede resultar en la filtración de datos sujetos a GDPR, la interrupción de servicios críticos, la manipulación de decisiones automatizadas y, en casos extremos, la toma de control total de infraestructuras sensibles.

Las consecuencias económicas también son notables: según Gartner, el coste medio de una brecha derivada de la explotación de agentes AI podría superar los 5 millones de euros, considerando tanto daños reputacionales como sanciones regulatorias (por ejemplo, bajo NIS2 o GDPR).

Medidas de Mitigación y Recomendaciones

Para mitigar estos riesgos, los expertos recomiendan adoptar un enfoque defense-in-depth, que incluya:

– Validación estricta de entradas y prompts antes de ser procesados por el modelo.

– Segmentación de redes y aislamiento de los entornos de ejecución de agentes AI.

– Monitorización continua de logs y patrones de interacción, con alertado ante desviaciones.

– Actualización regular de frameworks y dependencias, aplicando parches a las CVE identificadas.

– Implementación de controles de autenticación y autorización robustos entre agentes.

– Formación específica para desarrolladores en secure coding y gestión de contexto en IA.

Opinión de Expertos

Analistas de firmas líderes como Mandiant y NCC Group señalan que el MCP constituye una “zona gris” en la seguridad moderna, donde las técnicas tradicionales de hardening resultan insuficientes. “Estamos viendo una convergencia entre amenazas propias de la IA y TTP clásicos de APTs”, afirma Javier de la Fuente, CISO de una multinacional tecnológica. El consenso es que el sector debe evolucionar rápidamente para anticipar la sofisticación de los ataques dirigidos a agentes de IA.

Implicaciones para Empresas y Usuarios

Las organizaciones que integran agentes AI en sus procesos deben reevaluar sus estrategias de gestión de riesgos y cumplimiento normativo. Las auditorías de seguridad deben extenderse al ciclo de vida completo del agente, y los DPOs (Data Protection Officers) deben considerar el impacto de estas vulnerabilidades en términos de protección de datos personales. Para los usuarios finales, la principal recomendación es interactuar únicamente con agentes certificados y mantener una actitud crítica ante respuestas que impliquen acciones automatizadas.

Conclusiones

El ranking de las 25 principales vulnerabilidades del Model Context Protocol marca un punto de inflexión en la seguridad de la inteligencia artificial aplicada. La superficie de ataque de los agentes AI es amplia, dinámica y requiere de una respuesta coordinada entre desarrolladores, equipos de seguridad y reguladores. Solo mediante la adopción de buenas prácticas, herramientas avanzadas de detección y un enfoque proactivo se podrá mitigar el riesgo inherente a estos sistemas emergentes.

(Fuente: www.securityweek.com)